ADAS e detecção de objetos através de sistemas de câmera: o rápido desenvolvimento

Quase simultaneamente com a introdução do primeiro Tesla Model S, surgiu um novo nome na indústria automobilística: Mobileye. Enquanto muitos outros desenvolvedores de sensores para detecção de objetos estavam focados principalmente em grandes quantidades e enormes volumes de dados pré-carregados (mapas 3D do ambiente), a Mobileye se concentrou em um sistema de câmera única (o olho móvel) que pode avaliar completamente situações em tempo real. Neste artigo, abordamos as diferentes versões de direção autônoma que isso torna possível e como esse desenvolvimento continuará.

Mobileye EyeQ: autonomia de nível 2+

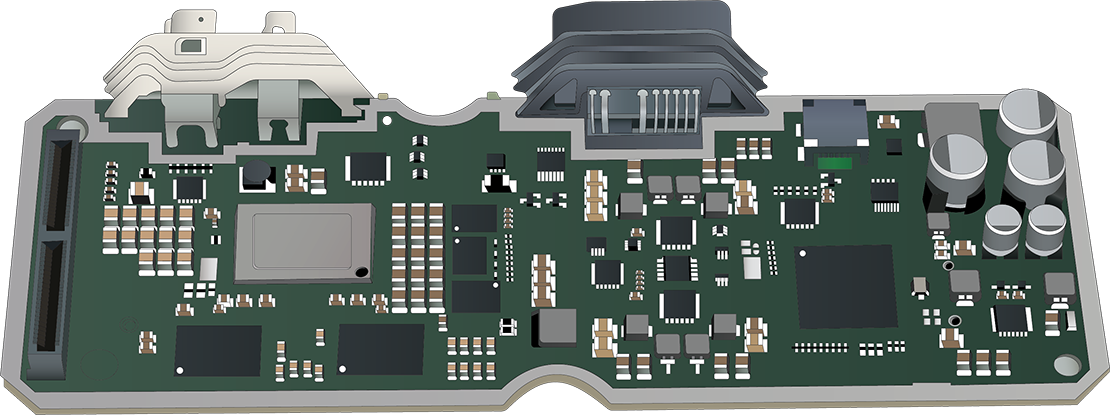

A base da tecnologia de câmera da Mobileye é a EyeQ: um SoC (System on Chip) especialmente desenvolvido. A EyeQ chamou a atenção imediatamente quando foi introduzida em 2007, atraindo vários grandes fabricantes de automóveis que estavam procurando um parceiro capaz de fornecer um sistema completo de ADAS. Atualmente, mais de 100 milhões (!) de unidades EyeQ foram vendidas em todo o mundo, distribuídas por mais de 700 modelos de mais de 35 fabricantes de automóveis diferentes. O modelo topo de linha mais recente em 2023, o EyeQ6H, possui um processador de sinal de imagem (ISP), um processador gráfico (GPU) e um codificador de vídeo próprios. Isso torna possível operar sistemas com autonomia de nível 2+. Até as formas mais avançadas de ADAS são possíveis com o SoC. Funções como aviso de saída de faixa, assistência de permanência na faixa, frenagem de emergência automática, aviso de colisão frontal, controle de cruzeiro adaptativo, reconhecimento de sinais de trânsito, assistente de luz alta e assistente de estacionamento podem ser realizadas com o SoC EyeQ. Em alguns casos, a câmera central ainda recebe assistência de radar.

Mobileye REM: autonomia de nível 3

Para alcançar a autonomia de nível 3 ou superior sem o uso de muitos sensores ou mapas 3D em larga escala, a Mobileye procurou uma maneira alternativa de conhecimento prévio que permitisse à EyeQ ter mais informações do que a câmera estava vendo naquele momento.

A solução veio em 2018 na forma de Road Experience Management (REM). Basicamente, é um sistema em que cada carro com um novo SoC EyeQ armazena continuamente informações sobre o mundo que a câmera vê. Todas essas informações são coletadas centralmente e convertidas em um Roadbook: um mapa em tempo real próprio que não apenas conhece o ambiente, mas também mostra como o trecho da estrada é usado e com que posicionamento. Essas informações são compartilhadas Over-The-Air (OTA) com outros veículos EyeQ, permitindo-lhes tomar decisões mais informadas no modo autônomo.

Você pode imaginar que, dadas as enormes quantidades de SoCs EyeQ em circulação, isso leva rapidamente a um conjunto completo e prático de informações. Especialmente porque esse sistema também pode avaliar em certa medida o comportamento de condução local e ajustar o comportamento autônomo de acordo. Inserir rapidamente em um tráfego urbano, por exemplo, é muito mais importante do que em uma área rural.

Mobileye SuperVision ADAS

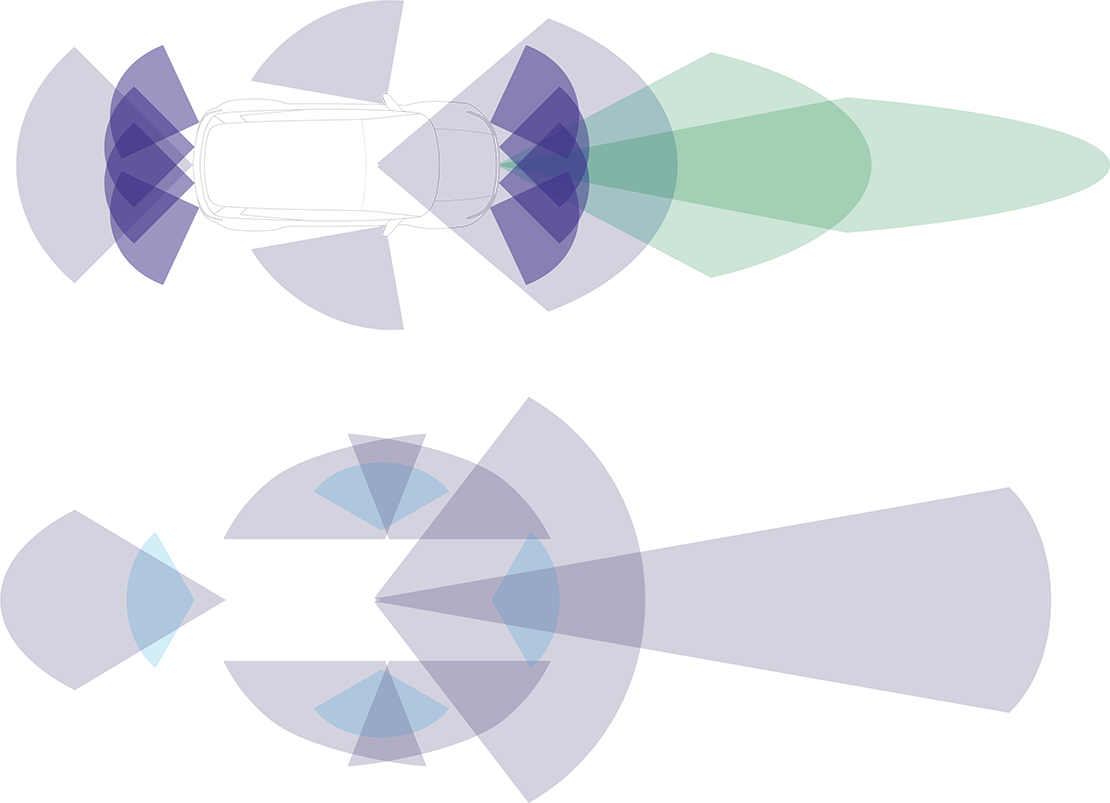

Quanto mais ADAS pode observar ao seu redor, melhor o sistema funciona e mais funcionalidades são possíveis. Em colaboração com a fabricante de automóveis Geely, o SuperVision foi introduzido: uma forma muito abrangente de ADAS com impressionantes 7 câmeras ambientais, 4 câmeras de estacionamento e 2 SoCs.

Com esse enorme upgrade, o SuperVision ADAS é capaz de reagir muito mais como um motorista físico faria. Por exemplo, se alguém estiver estacionado à beira da estrada com a porta aberta, o sistema manterá uma distância lateral um pouco maior. E se um pedestre estiver andando perto da estrada, o veículo diminuirá a velocidade. O sistema também é capaz de antecipar situações de trânsito muito melhor, como entrada e objetos que mudam de direção de repente. Em suma, é um desenvolvimento significativo.

Radar e LiDAR como backup

Para permitir que os veículos sejam totalmente autônomos (nível 5), os sistemas precisam ser extremamente confiáveis. E se você, assim como a Mobileye, confia apenas em câmeras, logo se depara com problemas. Não porque a condução autônoma apenas com câmeras não seja possível, mas porque não há backup para verificar se as câmeras estão vendo corretamente e se o sistema está tomando as decisões certas. Portanto, a decisão foi tomada de usar tanto o radar quanto o LiDAR. A abordagem é diferente, como a tabela a seguir mostra. A Mobileye não vê o radar e o LiDAR como adições para completar as informações, mas sim como mecanismos de controle para verificar o sistema da própria câmera. Eles chamam isso de 'verdadeira redundância'.

A Nvidia também está envolvida na condução autônoma

Enquanto a Mobileye se concentra em um sistema universal que pode ser implementado de forma relativamente simples em qualquer lugar, a gigante da tecnologia Nvidia tem uma visão diferente sobre os desafios da condução autônoma e a enorme quantidade de dados associada a ela. Como a Nvidia tem suas raízes na indústria de computação (gráfica), eles não veem a detecção de objetos como um sistema separado, mas como parte de um sistema maior: todo o carro. Um pouco como uma placa gráfica é parte de um PC completo.

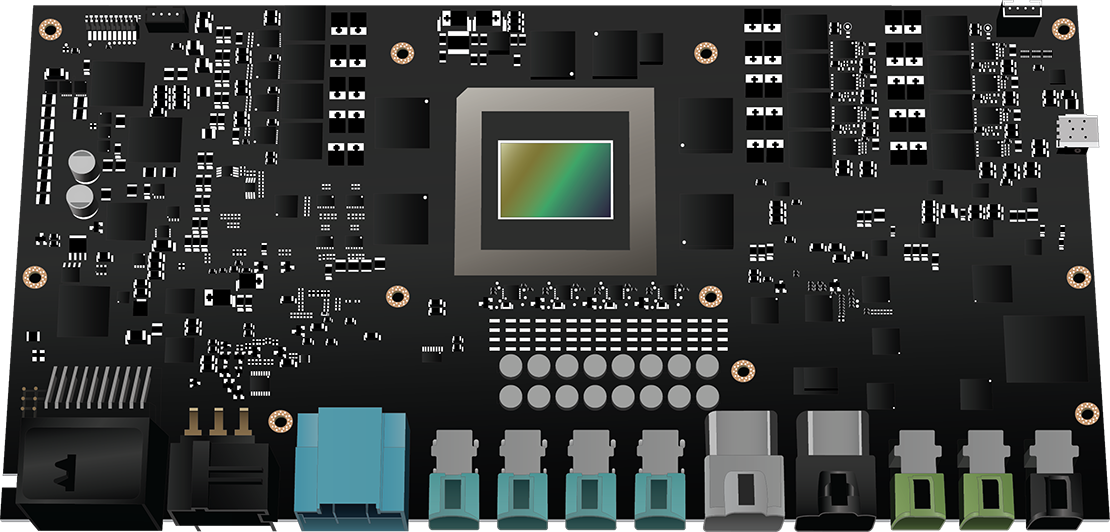

Em setembro de 2022, a Nvidia anunciou o "DRIVE Thor", um computador central abrangente que também gerencia sistemas como direção autônoma e estacionamento, monitoramento de ocupantes, entretenimento e painel de instrumentos digital. A enorme capacidade de processamento (2000 teraflops) é a principal característica do Thor e elimina a necessidade de várias unidades de controle separadas. Além disso, a plataforma permite a computação multi-domínio, permitindo que a direção autônoma funcione de forma completamente independente e segura, junto com outras funções dentro deste supercomputador.

Como a detecção de objetos afetará o gerenciamento do motor

Você provavelmente entendeu que todos esses sistemas podem influenciar significativamente as decisões da ECU. A mensagem que queremos transmitir com essas informações é que, devido a essa nova tecnologia, a diagnóstico nunca mais será o mesmo: o pedal do acelerador não é mais a única entrada à qual o gerenciamento do motor precisa reagir. Identificar a causa de um problema se tornará uma tarefa complexa: a ECU está realmente defeituosa? Ou ela simplesmente não está recebendo a entrada correta? E a causa está em outro lugar no carro?

da

da de

de en

en es

es fr

fr it

it nb

nb nl

nl sv

sv fi

fi